“文化变革在很大程度上是由领导者推动的,它需要能够产生能量、激励员工的方法论,也需要一种能够培育、奖励这种文化的治理模式,以解决人工智能在运营和伦理方面带来的转型挑战。在一个 AI 就绪的组织中,信任是至关重要的。”

——施博德(Brad Smith)

微软总裁兼首席法务官

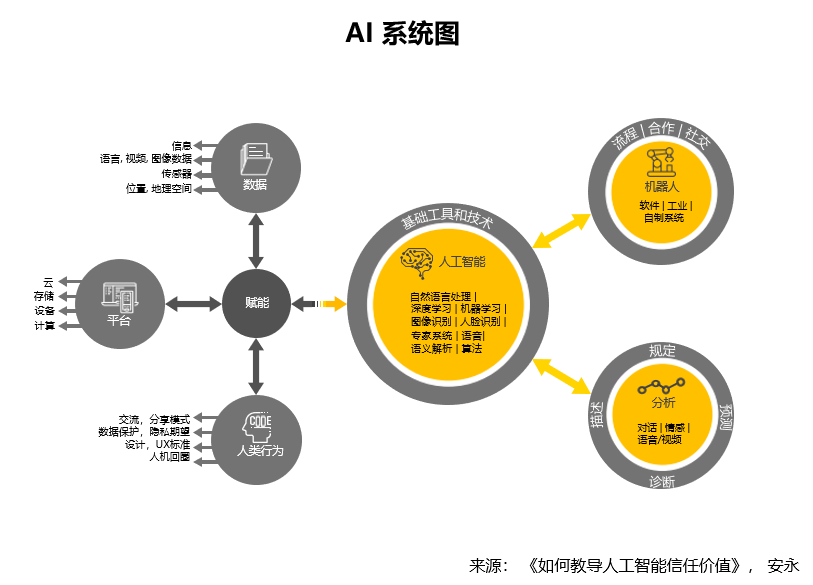

人工智能正被应用到越来越广泛的业务场景中,以实现在以往由人执行的活动和任务上的自动化。对于 AI 系统的设计人员、架构师和开发人员而言,充分意识到 AI 相关法规和社会影响变得越来越重要。此外,他们还应该采用符合道德规范的设计以及参考 AI 治理方面的最佳实践。

建立对人工智能的信任

AI 的负面影响包括运营压力、诉讼、负面新闻、客户流失、盈利能力降低和监管审查等,其中个人数据滥用问题更可能导致企业公信力危机。

安永开发的 AI 框架可以帮助企业了解可能会影响系统、产品、品牌和声誉的潜在风险。框架的核心着重在AI相关系统。企业必须了解、治理、调整和保护 AI 系统内部和相连的所有组件才能达到对 AI 完全信任。

要建立对 AI 的信任既需要技术也需要企业文化的支持。AI 要想被用户接受,AI 首先需要能够被理解,也就是说其决策框架是可以解释和验证的。AI 还需要达到预期的性能,并且得到可靠的产出结果。

建立负责任的人工智能

前微软全球执行副总裁,微软人工智能及微软研究事业部负责人沈向洋博士与微软公司总裁,首席法务官施博德(Brad Smith)在《计算未来 人工智能及其社会角色》一书中强调负责任的人工智能所需的六个原则[1]:“公平,可靠,隐私与保障,包容,透明,负责。”

建立可信任人工智能的重要步骤

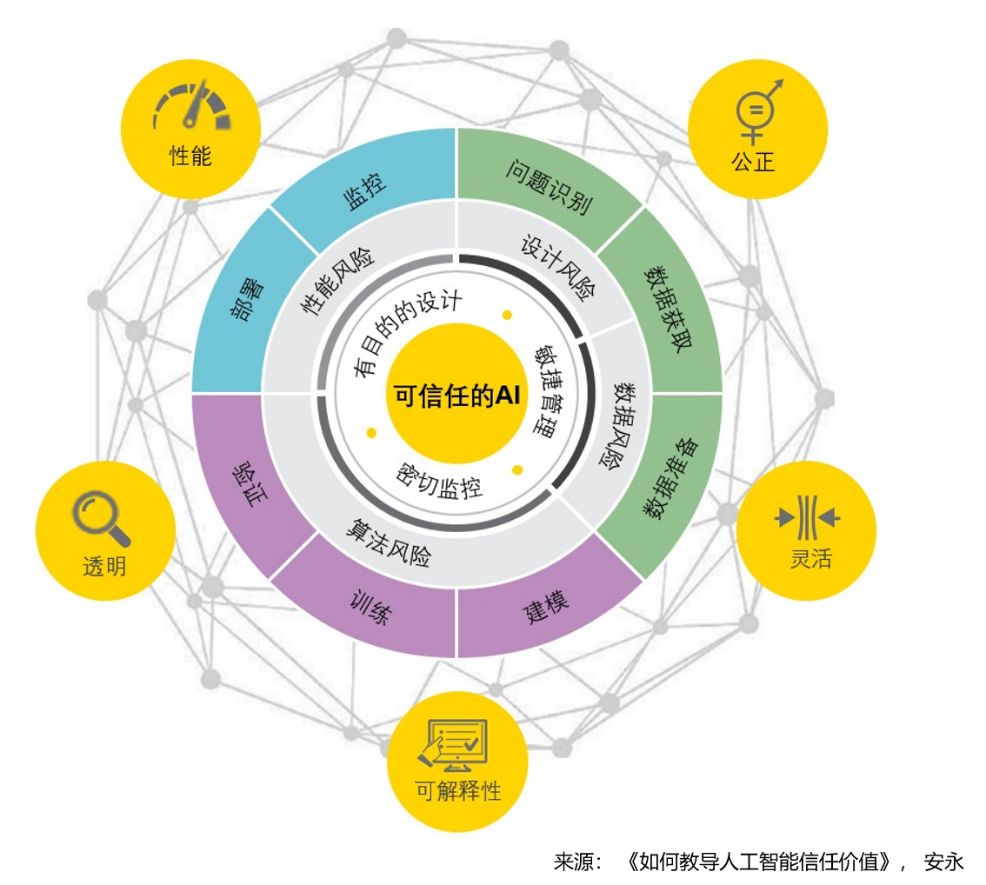

安永认为可信任的人工智能是基于以下三个重要步骤:

目的性设计:有目的地设计和构建系统,维护机器人、智能和自主功能之间的平衡,关注因果关系、限制条件、准备情况和相应风险

敏捷治理:从社会、法规、声誉和道德领域出发,识别并跟踪新出现的问题,为流程治理提供指导。在过程中保障流程管理系统的完整性、系统使用、架构和嵌入式组件、数据寻源和管理、模型训练和监控

密切监控:持续微调、整合和监控系统,以确保性能的可靠性,发现和纠正偏差并提高透明度和包容性

“教育 AI 就像养育孩子一样,你不仅需要教 AI 怎样做一件事,还要教它社会规范和价值观。开发人员在 AI 设计和开发之初就应该考虑到道德和信任风险。”

——凯茜·科比(Cathy Cobey)

安永全球人工智能信任主管合伙人

建立可信任的AI的治理模式

尽管越来越多企业意识到 AI 必须符合道德规范并具备可信赖性,但要确保 AI 的透明、公正、安全、准确和可审核性可能会超出开发人员的能力。企业需要建立可信任的 AI 生态系统。

微软已经设立了开发和研究人工智能与道德标准(AETHER)委员会。该委员会囊括了来自微软公司开发、研究、咨询和法律部门的高管,专注于积极制定内部政策,以及如何应对所出现的具体问题。AETHER 委员会审查和界定最佳实践,提供指导原则,指导微软人工智能产品和解决方案的开发和部署,并帮助解决微软人工智能研究、产品和客户沟通中产生的伦理和社会影响问题。

微软协同安永提供帮助

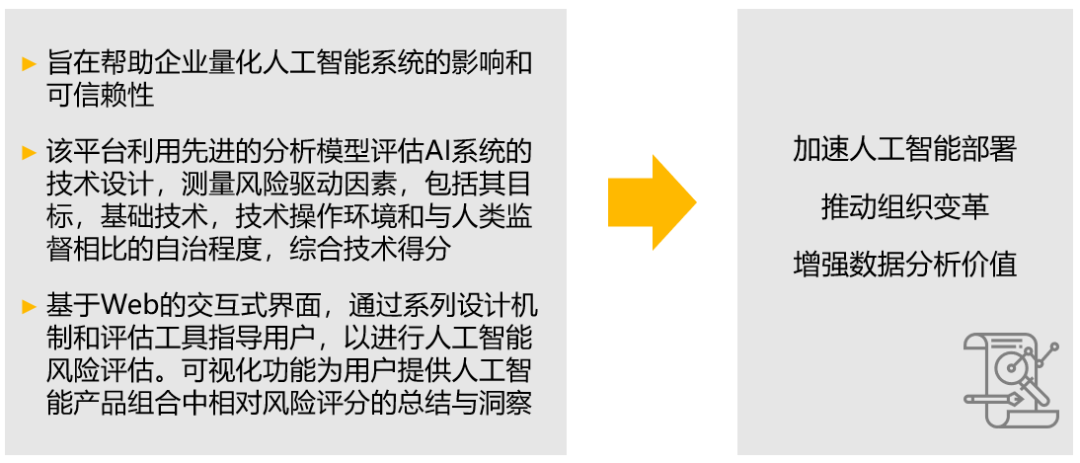

由微软 Azure 支持的安永可信赖人工智能平台(EY Trusted AI Platform)为用户提供了一种集成的方法来评估,监视和量化 AI 的影响和可信赖性。

人工智能在各个行业的应用和未来发展趋势受到热议,敬请关注下一期 AI 成熟度调研系列文章,来自微软和安永的行业专家将对热点问题答疑解惑。

[1]《计算未来 人工智能及其社会角色》

参考文献:《如何教导人工智能信任价值》, 安永返回搜狐,查看更多